Seguro que muchos recordáis la escena de 'Blade Runner' en la que Rick Deckard usaba el test Voight-Kampff para saber si Rachael era o no una replicante. Aquello, por supuesto, era ciencia-ficción, pero como ha ocurrido otras veces en el mundo del cine, ahora ese concepto trata de despojarse de esa segunda parte del término y convertirse solo en ciencia, sin más.

En su estudio, llamado "Automated Inference on Criminality using Face Images" (Inferencia Automatizada de la Criminalidad usando Imágenes Faciales") Xiaolin Wi y Xi Zhang aseguran haber encontrado un método que tenía éxito en esa identificación de criminales.

El sistema se nutrió de las fotografías de 1.856 ciudadanos chinos, hombres de entre 18 y 55 años, que no tenían ni pelo facial ni cicatrices o cualquier otro tipo de marcas en sus rostros. De todos ellos aproximadamente la mitad eran 730 criminales convictos, y 235 habían cometido crímenes violentos.

A partir de ese grupo de datos se observaron cuatro características faciales diferenciadoras para tratar de inferir la criminalidad, y detectaron que todos ellos eran útiles y que ayudaban a diferenciar rasgos faciales que según ellos hacían que el algoritmo pudiera detectar si una persona era o no uno de esos criminales convictos.

Entre las características tomadas en cuenta para el estudio estaban la curvatura de los labios, la distancia entre la esquina interior del ojo o el llamado ángulo nariz-boca. "Mediante la experimentación extensiva y una vigorosa validación cruzada", aseguraban los investigadores, "hemos demostrado que mediante un aprendizaje automático supervisado, los clasificadores faciales basados en datos son capaces de hacer una inferencia eficiente de la criminalidad".

Uno de esos clasificadores basado en redes neuronales convolucionales lograba una precisión del 89,51% en dichas pruebas. Aún así estos investigadores admitían que estaban en un "terreno pantanoso" en este ámbito, y no les faltaba razón: los algoritmos pueden ser racistas, pero no por su culpa, sino por la nuestra.

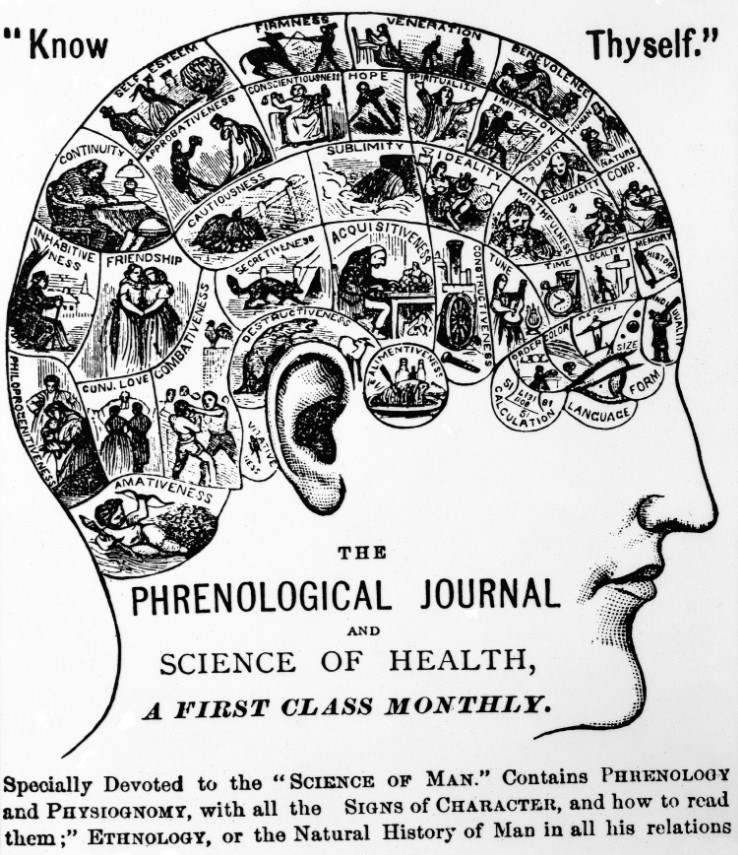

Frenología, esa pseudociencia

Tratar de determinar si ciertos rasgos faciales pueden identificar a un criminal o, ya puestos, a una persona más o menos inteligente nunca han dado demasiados frutos. Este tipo de investigaciones siempre han sido un quiero y no puedo, y el ejemplo perfecto lo tenemos en la frenología.

Esta teoría pseudocientífica iba precisamente por este camino al que apunta este algoritmo: afirmaba que era posible determinar "el carácter y los rasgos de la personalidad, así como las tendencias criminales, basándose en la forma del cráneo, cabeza y facciones.

Esta disciplina fue desarrollada a finales del siglo XVIII por el anatomista y fisiólogo alemán Franz Joseph Gall, y se hizo muy popular en el siglo XIX. George Combe, un abogado escocés, la popularizó en Gran Bretaña, y en su 'A System of Phrenology' recogió las enseñanzas de Gall.

Nuestro compañero Sergio Parra hablaba del tema largo y tendido en Xataka Ciencia hace años: los rasgos faciales se convirtieron en el pasado en símbolos inequívocos de ciertos tipos de personalidad: hay quien trató de evaluar el intelecto a partir de la pendiente de la nariz, y aberraciones como la eugenesia también trataban de favorecer ciertos nacimientos e impedir otros que "empeorarían la especie", por así decirlo.

Kate Crawford, investigadora de investigación artificial en Microsoft Research, el MIT y la Universidad de Nueva York, explicaba en The Intercept que para ella este estudio era "frenología literal, solo que está usando herramientas modernas de aprendizaje automático supervisado en lugar de calibradores. Es pseudociencia peligrosa".

No somos objetivos, y nuestros algoritmos tampoco lo son

Los algoritmos que definen el comportamiento de un sistema de inteligencia artificial están programados por seres humanos que tienen una forma de pensar y unas opiniones concretas. El problema es que es casi imposible impedir que esos factores subjetivos acaben actuando en ese motor de inteligencia artificial.

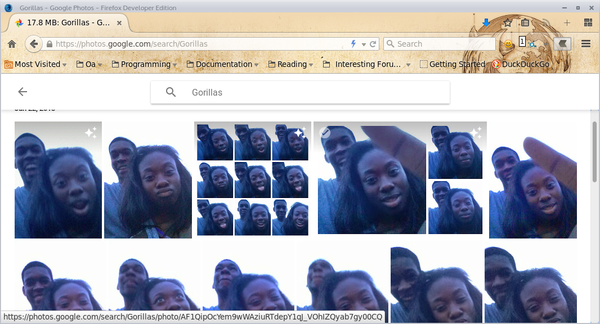

No es algo que nos pille de sorpresa. El algoritmo de Google ha sido tildado de racista una y otra vez, pero lo mismo podría decirse de Snapchat y, por supuesto, de Tay, ese chatbot que Microsoft tuvo que retirar de Twitter antes de que la liara parda con más comentarios polémicos.

Precisamente una de las críticas más fuertes que se ha realizado a este estudio en sitios como Hacker News es que al introducir ciertos parámetros de objetividad en un sistema de aprendizaje automático hacemos que la máquina actúe en base a esa objetividad. O más bien, en base a esa subjetividad, que existe porque quien controla qué datos entran y cómo se clasifican es el responsable último de cómo se comporta ese algoritmo.

Ese argumento puede ser perfectamente válido, pero insistimos: el problema no es de las computadoras, sino de aquellos que las programamos y establecemos qué tipo de conjuntos de datos sirven para que estas aprendan, y cómo se clasifican esos datos. Y las máquinas no pueden hacerlo solas. Al menos, no de momento.

La noticia Que la inteligencia artificial reconozca a los criminales por su cara parece ciencia ficción porque lo es (por ahora) fue publicada originalmente en Xataka